Herkese Merhabalar Sevgili Teknoloji Dostları ve Gizlilik Avcıları! 🛡️

Şimdi gelin, hepimizin o “vay be!” dediği, hayatımıza bir anda girip her şeyi değiştiren ChatGPT, Gemini, Claude gibi yapay zeka devlerine bir kez daha bakalım. Kabul edelim, bu bulut tabanlı sihirbazlar inanılmaz şeyler yapıyorlar. Karmaşık kodları çözüyor, makaleler yazıyor, hatta en saçma sorularımıza bile mantıklı cevaplar verebiliyorlar. Adeta bilgiyi parmaklarının ucunda tutan birer sihirbaz edasıyla çalışıyorlar.

Ama sevgili dostlar, bu sihrin arkasında, çoğumuzun göz ardı etmeye çalıştığı, üzerine titrediği bir gerçek var: Veri. Bizim verimiz. Yazdığımız her satır, sorduğumuz her soru, paylaştığımız her fikir, o dev sunuculara doğru bir yolculuğa çıkıyor. Ve o yolculuktan sonra verilerimizin başına ne geldiği konusunda tam bir şeffaflık çoğu zaman yok.

Biliyorsunuz ki, teknoloji dünyasında “bedava” diye bir şeyin olmadığını artık hepimiz ezberledik. Eğer bir ürün için para ödemiyorsak, ürün genellikle bizizdir. Bulut tabanlı YZ servislerinde bile, “Verileriniz model eğitiminde kullanılmaz” deseler dahi, politikaların gelecekte değişmeyeceğinin garantisi yok. Kurumsal sırların, hassas projelerin, kişisel günlüklerimizin veya en mahrem sorularımızın başkalarının sunucularında durması fikri bile içimi ürpertiyor. Benim için bu durum, evinizin anahtarını tanımadığınız birine verip, “Kullanmazsın ama yine de sende dursun” demek gibi bir şey!

İşte tam da bu noktada, yerel yapay zeka çözümlerinin cazibesi devreye giriyor. Kendi bilgisayarınızda DeepSeek veya Llama gibi güçlü bir modeli çalıştırmak, aslında dijital egemenliğinizi geri almak anlamına geliyor. Bu, sadece bir gizlilik meselesi değil, aynı zamanda özgürlük ve kontrol meselesi. Artık bir servisin kısıtlamalarına, API limitlerine, sansür uygulamalarına ya da anlık sunucu çökmelerine bağlı kalmıyorsunuz. Kendi kütüphaneniz, kendi kurallarınız geçerli oluyor.

Elbette, bu işin bir “bedeli” var; o da donanım gücü. İyi bir yerel YZ deneyimi için hatırı sayılır bir ekran kartına ihtiyacınız oluyor. Ama bu, bir kerelik bir yatırım ve karşılığında elde ettiğiniz mahremiyet ve kontrol hissi paha biçilmez. Sanki evinizde kendi elektrik santralinizi kurmak gibi bir şey; ilk başta biraz uğraş gerektirse de, sonrası tamamen size ait bir bağımsızlık ve huzur oluyor.

Peki, madem bu kadar cazip, o zaman gelin bu dijital kütüphaneyi kurmak için ne tür hazırlıklar yapmamız gerektiğine bir göz atalım.

DeepSeek ve Llama ile Yerel Yapay Zeka Kurulum Rehberi

“Yerel yapay zekanın kalbi, ekran kartınızın belleğinde (VRAM) atar. Niceleme (Quantization) mucizesi sayesinde, 8GB VRAM ile bile bir devin gücünü kontrol etmeyi başarabilirsiniz. İşte Nodus Labs’ın önerdiği en kolay ve en güvenli yol:”

Yerel LLM çalıştırmanın anahtarı, modeli küçülten Niceleme (Quantization) işleminden geçmiş GGUF formatındaki modelleri kullanmaktır. Bu modelleri yönetmek için en çok önerilen açık kaynak araç ise Ollama‘dır.

🧠 Hazırlık: Ollama ve Model Seçimi

- Ollama Yazılımını Edinin: Yerel LLM’leri yönetmek için en iyi açık kaynaklı araç olan Ollama’yı (Mac, Windows veya Linux için) resmi web sitesinden indirin ve kurun.

- Modeli Çalıştırın: Komut istemcisini (Terminal) açın. DeepSeek R1:8B gibi daha küçük ve verimli modeller, ortalama bir bilgisayarda bile iyi çalışır. Modeli indirip çalıştırmak için tek bir komut yeterlidir:

ollama run deepseek-r1:8b- Not: Bu komut, modeli otomatik olarak indirir ve yerel sunucunuzda (

http://localhost:11434) çalışır duruma getirir.

🖥️ Arayüz Seçimi: Gizlilik Dostu Etkileşim Yolları

Modeliniz artık yerel sunucunuzda çalışıyor! Şimdi sıra, onunla konuşabileceğiniz güvenli bir arayüz seçmekte.

🏆 Benim Tavsiyem: VSCode + “Continue” Uzantısı

Bu, özellikle kod yazanlar ve bağlam kontrolüne önem verenler için en kolay ve en güvenli yoldur:

- VSCode’u Kurun: Açık kaynaklı ve popüler kod düzenleyici olan VSCode’u indirin.

- “Continue” Uzantısını Ekleyin: VSCode içindeki uzantılar marketinden “Continue” adlı açık kaynaklı YZ chatbot uzantısını kurun.

- Hemen Başlayın: Uzantıyı açtığınızda, Ollama üzerinden kurduğunuz DeepSeek modelini otomatik olarak algılayacaktır. VSCode’da açtığınız klasör ve dosyalar, modeliniz için otomatik olarak bağlam (context) haline gelir. Bu, kodlarınızın gizliliğini korurken, modelin kodlarınız hakkında yardım sunması anlamına gelir.

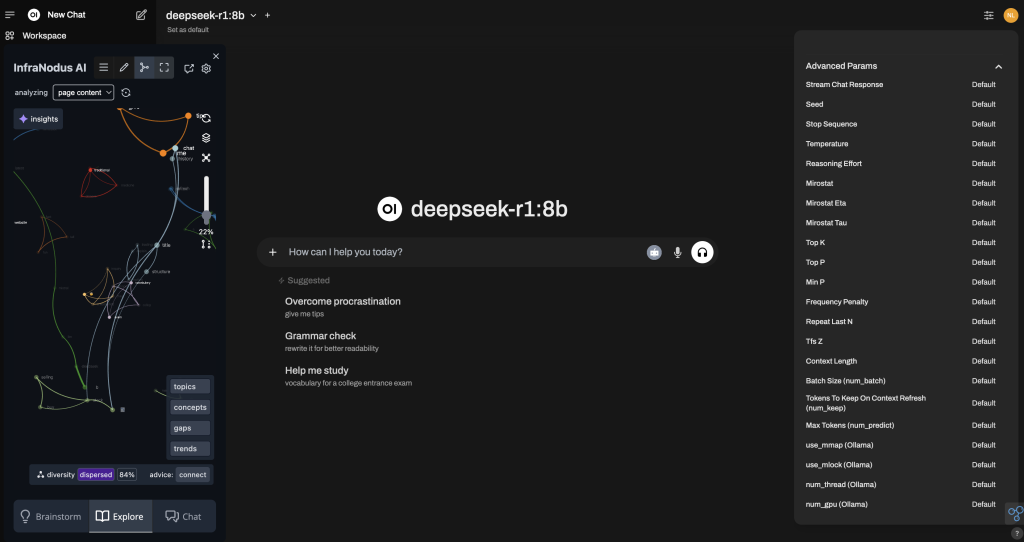

🌐 İkinci Seçenek: Open-WebUI (ChatGPT Benzeri Arayüz)

Eğer tam teşekküllü, web tarayıcısı tabanlı bir sohbet arayüzü isterseniz Open-WebUI‘ı kurabilirsiniz. Bu, bir miktar Terminal bilgisi ve Docker kurulumu gerektirse de, model parametrelerini daha iyi kontrol etmenizi ve tıpkı ChatGPT gibi bir arayüzde yerel YZ’nizle konuşmanızı sağlar.

📱 Üçüncü Seçenek: Harici Uygulamalar

Ollama’nın sunduğu yerel sunucu linkini (http://localhost:11434) kabul eden Enchanted gibi açık kaynaklı harici mobil veya masaüstü uygulamaları da kullanabilirsiniz. Bu seçenek, daha az kontrol imkanı sunsa da, modeli telefonunuzda veya farklı cihazlarda kullanmanızı sağlar.

AI Asistanınızla Hayatı Hacklemek: Derinlemesine Örnek Senaryolar

“Yerel YZ’nizi kodlamadan analize, hassas veriden beyin fırtınasına kadar hayatınızın her alanında bir hack aracına dönüştürün. Bu güç, sadece size ait!”

Artık DeepSeek ve/veya Llama gibi güçlü bir yapay zeka asistanı bilgisayarınızda çalışıyor. İşte bu gücü en verimli şekilde kullanmanız için bazı somut ve detaylı örnekler:

💻 Yazılımcılar ve Veri Analistleri İçin Somut Örnekler (DeepSeek Coder İle)

- Hassas Kod İncelemesi ve Optimizasyon:

- Prompt Örneği: “Sen kıdemli bir yazılım mühendisisin. Bu Python kodunu güvenlik açıkları, performans darboğazları açısından analiz et. Ayrıca bu fonksiyona uygun, 3 farklı durumu kapsayan unittest test senaryoları üret. Cevabı sadece markdown kod bloğu içinde ver.” (Kodunuzu yapıştırın. Bu işlem tamamen yerelde kalır.)

- Veritabanı Şeması Oluşturma:

- Prompt Örneği: “Yeni bir e-ticaret uygulaması için müşteriler, siparişler ve ürünler tablolarını kapsayan bir PostgreSQL şeması oluştur. Tüm tablolarda ‘id’ alanı primary key olsun. Çıktıyı tam ve eksiksiz SQL DDL kodu formatında ver.”

📈 Araştırmacılar ve Yazarlar İçin Gizlilik Odaklı Örnekler (Genel LLM’ler İle)

- Hassas Doküman Özeti ve Analizi:

- Prompt Örneği: “Bu şirket içi iş raporunu 4 ana maddede özetle. Rapordaki en büyük 2 risk faktörünü ve bu risklere karşı önerilen eylem planlarını çıkar. Unutma, bu hassas bir ticari sırdır, hiçbir yere göndermemelisin.“ (Uzun metninizi yapıştırın. Yerel modeliniz bağlam penceresi dahilinde metni analiz eder.)

- Yaratıcı Beyin Fırtınası ve İçerik Üretimi:

- Prompt Örneği: “Sen bir marka danışmanısın. Konusu ‘Yerel Yapay Zeka ve Gizlilik’ olan yeni bir teknoloji blogu için 10 farklı, akılda kalıcı başlık öner. Önerileri 5 kelimeyi geçmeyecek şekilde kısa tut. Her başlığın yanına birer emoji ekle.”

👑 Profesyonel Kullanım İpuçları

- Prompt Engineering Hâlâ Kraldır: Modeline rol atayın, format belirtin ve çıktı beklentinizi netleştirin.

- Bağlam Penceresini Yönetin: Çok uzun metinler veya sohbet geçmişi sunmaktan kaçının; modelin “unutmaya” başladığını fark ederseniz sohbeti bölerek ilerleyin.

- Düşük Nicelenmiş Modellere Geri Dönün: Eğer sürekli “Out of Memory” hatası alıyorsanız, daha düşük nicelenmiş (Q3_K_S, Q4_K_M gibi) bir model versiyonunu indirin.

DeepSeek ve Llama Ailesinin Artıları ve Eksileri)

“Yerel YZ dünyasında iki büyük oyuncu var: Kodlama yeteneğiyle öne çıkan DeepSeek ve topluluk desteğiyle sınırsız türevlere sahip Llama ailesi. Doğru modeli seçmek, dijital bağımsızlığınızın ilk ve en önemli adımıdır.”

Yerel olarak çalıştırabileceğimiz modeller arasında en çok konuşulan ve en verimli sonuçlar veren iki ana aile var:

🌟 DeepSeek Modelleri (DeepSeek Coder / DeepSeek LLM)

DeepSeek, özellikle Coder versiyonu ile ün kazandı.

| Artıları (+) | Eksileri (-) |

| Mükemmel Kodlama Yeteneği: Kod tamamlama, hata ayıklama ve karmaşık algoritmaları açıklamada rakipsiz. | Daha Az Genel Bilgi: Genel dünya bilgisi ve yaratıcı yazım konusunda Llama türevlerinin bazılarının gerisinde kalabilir. |

| Yüksek Performans: Belirli görevlerde (özellikle kodlamada) çok keskin ve hızlı sonuçlar verir. | Daha Küçük Topluluk: Llama’ya göre türevleri ve özelleştirilmiş versiyonları daha azdır. |

Kişisel Deneyimim: Kritik projelerde kodlarımı bulut tabanlı LLM’lere yapıştırmakta hep bir tedirginlik yaşarken, DeepSeek Coder’ı yerel olarak kurup çalıştırmaya başladığımda işte o zaman gerçek bir nefes aldım. Sanki kendi özel, süper zeki kodlama asistanım odamda benimle birlikte çalışıyordu.

🦙 Llama Modelleri (Meta Llama, Mistral, Code Llama, vb.)

Meta’nın yayınladığı Llama ve ondan türeyen Mistral, Code Llama gibi modeller, açık kaynak topluluğunun adeta temel taşı haline geldi.

| Artıları (+) | Eksileri (-) |

| Devasa Topluluk Desteği: Yüzlerce ince ayarlı (finetuned) ve optimize edilmiş türevi mevcuttur (Mistral, Mixtral gibi). | Tutarsız Performans: Türev modelin kalitesi, onu geliştiren topluluğa bağlıdır; bazıları çok iyi, bazıları zayıf olabilir. |

| Mükemmel Genel Bilgi ve Yaratıcılık: Metin oluşturma, hikaye yazma ve genel sorulara cevap vermede çok güçlüdür. | Kodlamada İkinci Sınıf (Code Llama hariç): Genel modelleri, DeepSeek Coder kadar kodlama görevlerinde keskin değildir. |

| Esneklik: Küçük boyutlu (3B, 7B) ve büyük boyutlu (70B) versiyonları mevcuttur, farklı donanımlara uyum sağlar. | Donanım Açgözlülüğü: En büyük modellerini çalıştırmak için profesyonel seviyede VRAM gereklidir. |

Sonuç: Eğer önceliğiniz kodlama ve teknik analiz ise DeepSeek Coder’ı tercih edin. Eğer daha çok yaratıcı yazım, genel bilgi ve deneme yanılma ile topluluk tarafından geliştirilmiş en iyi modeli bulmak istiyorsanız, Llama ailesinden bir türevi (Mistral gibi) indirin.

🛠️ 2. Bölüm: DeepSeek’i Cebimize İndirirken Donanımımızla Dans Etmek: Hazırlık ve Kurulum

“Yerel yapay zekanın kalbi, ekran kartınızın belleğinde atar. Bu dansın figürlerini doğru öğrenerek, 8GB VRAM ile bile bir devin gücünü kontrol etmeyi başarabilir, ‘CUDA out of memory’ hatalarına veda edebilirsiniz!”

🧠 Donanımımız: VRAM’in Önemi ve Niceleme Mucizesi

Yerel bir modeli çalıştırmanın temelinde, güçlü bir Ekran Kartı (GPU) ve onun belleği, yani VRAM (Video RAM) yatıyor. Modelin milyarlarca parametresini aynı anda işlemek zorundasınız.

7B’lik bir modeli tam hassasiyetle çalıştırmak tüketici kartları için imkansızdır. İşte bu noktada “quantization” (niceleme) adı verilen sihirli bir işlem devreye giriyor. Niceleme, modelin ağırlıklarını daha düşük bit derinliklerine (örneğin 4-bit integer’a) sıkıştırarak modelin boyutunu ve VRAM ihtiyacını düşürür.

Bu sayede, 7B’lik bir modelin 4-bit nicelenmiş (GGUF) versiyonu, 8GB-12GB VRAM’e sahip bir kartta bile çalışabilir hale gelir. Doğru nicelenmiş modeli seçmek, bu işte başarının anahtarıdır!

⚙️ Modelleri Çalıştırma Araçları: LM Studio ve Ollama

Bu GGUF formatındaki modelleri çalıştırmanız için iki ana kapı var:

1. LM Studio: Görsel ve Kullanıcı Dostu Arayüz Harikası

- LM Studio’yu indirin. “Search” sekmesine gidin ve arama çubuğuna “DeepSeek Coder” veya “Mistral” yazın.

- Örnek Kullanım: VRAM’inize uygun bir nicelenmiş GGUF modeli (örn. Q4_K_M) seçip indirdikten sonra, “My Models” sekmesindeki Chat arayüzünde hemen kullanmaya başlayabilirsiniz. Görsel arayüz sayesinde hangi modelin kartınıza uygun olduğunu anında görürsünüz.

2. Ollama: Hızlı ve Geliştirici Dostu Komut Satırı Sihirbazı

- Ollama’yı resmi web sitesinden indirip kurun.

- Komut istemcisini açın ve sadece şunu yazın:

ollama pull deepseek-coderveyaollama pull mistral. - Çalıştırmak için:

ollama run deepseek-coder. - Örnek Kullanım: Ollama, hafif ve hızlı olduğu için, kendi Python uygulamalarınızla veya web arayüzlerinizle API üzerinden entegre etmek için idealdir. Örneğin, bir

curlkomutuyla bile yerel YZ’nize soru sorabilirsiniz.

💡 3. Bölüm: Yerel AI Asistanınızla Hayatı Hacklemek: Derinlemesine Örnek Senaryolar

“Sadece ‘Merhaba, nasılsın?’ demek için bu gücü kullanmayın! Yerel YZ’nizi kodlamadan analize, hassas veriden beyin fırtınasına kadar hayatınızın her alanında bir hack aracına dönüştürün.”

Artık DeepSeek ve/veya Llama gibi güçlü bir yapay zeka asistanı bilgisayarınızda çalışıyor. İşte bu gücü en verimli şekilde kullanmanız için bazı somut ve detaylı örnekler:

💻 Yazılımcılar ve Veri Analistleri İçin Somut Örnekler (DeepSeek Coder İle)

DeepSeek Coder, hassasiyet gerektiren teknik görevlerde parlar:

- Hassas Kod İncelemesi ve Optimizasyon:

- Ne Yapılır: Bulut servisine göndermekte çekindiğiniz şirket içi kritik bir fonksiyona ait 50 satırlık Python kodunu yapıştırın.

- Prompt Örneği: “Sen kıdemli bir yazılım mühendisisin. Bu Python kodunu güvenlik açıkları, performans darboğazları açısından analiz et. Ayrıca bu fonksiyona uygun, 3 farklı durumu (başarılı, hata, kenar durum) kapsayan unittest test senaryoları üret. Cevabı sadece markdown kod bloğu içinde ver.”

- Veritabanı Şeması Oluşturma:

- Ne Yapılır: Yeni bir e-ticaret platformu için tabloların (Ürünler, Siparişler, Müşteriler) gereksinimlerini listeleyin.

- Prompt Örneği: “Yeni bir e-ticaret uygulaması için müşteriler, siparişler ve ürünler tablolarını kapsayan bir PostgreSQL şeması oluştur. Tüm tablolarda ‘id’ alanı primary key olsun. ‘Müşteriler’ tablosunda e-posta alanı için UNIQUE kısıtlaması ekle. Çıktıyı tam ve eksiksiz SQL DDL kodu formatında ver.”

📈 Araştırmacılar ve Yazarlar İçin Gizlilik Odaklı Örnekler (Genel LLM’ler İle)

Llama türevleri veya genel DeepSeek LLM, metin tabanlı ve yaratıcı görevlerde harikadır:

- Hassas Doküman Özeti ve Analizi:

- Ne Yapılır: Bir iş raporunun veya akademik makalenin içeriğini (örneğin 3000 kelime) kopyalayıp yerel YZ’ye yapıştırın.

- Prompt Örneği: “Bu raporu 4 ana maddede özetle. Rapordaki en büyük 2 risk faktörünü ve bu risklere karşı önerilen eylem planlarını çıkar. Cevabı madde işaretli liste olarak formatla. Unutma, bu hassas bir ticari sır içeren metindir, hiçbir yere göndermemelisin.”

- Yaratıcı Beyin Fırtınası ve İçerik Üretimi:

- Ne Yapılır: Yeni bir blog yazısı fikri veya projenizin isimlendirme süreci için yaratıcı bir ortak arayın.

- Prompt Örneği: “Sen bir marka danışmanısın. Konusu ‘Yerel Yapay Zeka ve Gizlilik’ olan yeni bir teknoloji blogu için 10 farklı, akılda kalıcı başlık öner. Önerileri 5 kelimeyi geçmeyecek şekilde kısa tut. Her başlığın yanına birer emoji ekle.”

⚠️ Unutulmaması Gerekenler

- Prompt Engineering Hâlâ Kraldır: Unutmayın, ne kadar iyi bir yönerge verirseniz, o kadar iyi sonuç alırsınız.

- Düşük Nicelenmiş Modellere Geri Dönün: Eğer sürekli “Out of Memory” hatası alıyorsanız, daha düşük nicelenmiş (Q3_K_S, Q4_K_M gibi) bir model versiyonunu indirin. Performansınız düşse bile, mahremiyetiniz ve kontrolünüz baki kalır.

- Entegrasyon Gücünü Keşfedin: Ollama’nın yerel API’sini kullanarak, basit bir Python scripti ile kendi özel YZ aracınızı (örneğin, belirli bir klasöre düşen PDF’leri otomatik özetleyen bir araç) bile geliştirebilirsiniz.

Bu yolculuk, bana sadece teknik bilgiler öğretmekle kalmadı, aynı zamanda dijital dünyadaki bağımsızlığımızın ne kadar önemli olduğunu bir kez daha gösterdi. Artık verilerinizin nereye gittiği konusunda endişelenmenize gerek kalmadan, yapay zekanın sunduğu tüm nimetlerden tam olarak faydalanabilirsiniz.